Projekt „Mensch.Maschine.Kultur – Künstliche Intelligenz für das Digitale Kulturelle Erbe in der Staatsbibliothek zu Berlin“

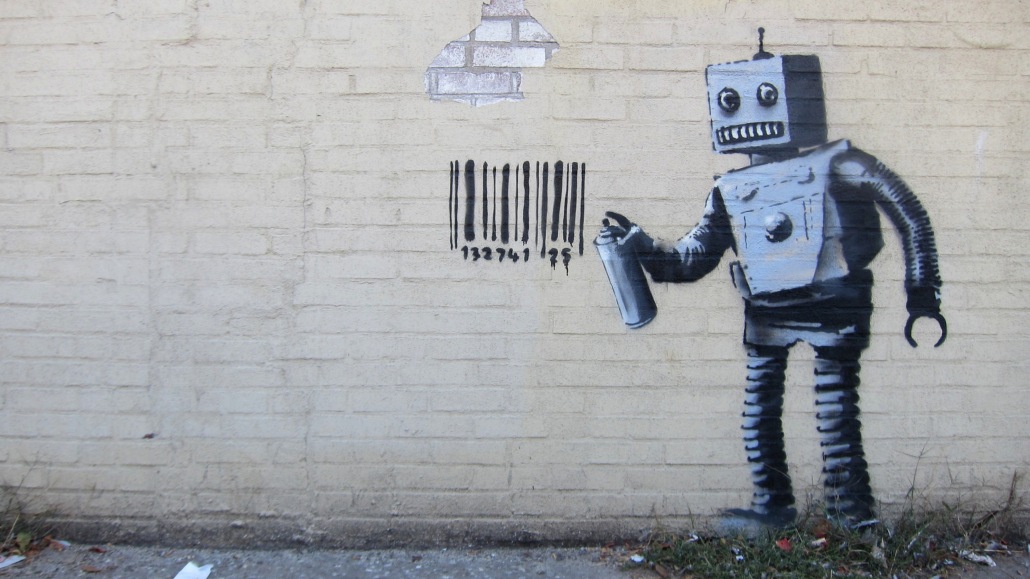

© Scott Lynch/Flickr – CC BY-SA 2.0

Allgemeine Projektinformationen und Hintergrund

Kulturerbeeinrichtungen wie Bibliotheken, Archive und Museen haben in den letzten 25 Jahren enorm viele Objekte digitalisiert. Diese Digitalisate liegen zumeist als Scans vor, also in einem Bildformat. Um diese Daten beispielsweise für die Forschung, aber auch für den Kultur- und Kreativsektor nutzbar zu machen, müssen die Inhalte dieses digitalisierten Kulturerbes aus den Bildern herausgezogen werden. So sollen beispielsweise Texte und deren Layout erkannt werden, damit ein Computer mit diesen Inhalten arbeiten kann. Hier setzt das Projekt „Mensch.Maschine.Kultur“ an, indem es Verfahren der künstlichen Intelligenz (KI) einsetzt. Das Wort „Maschine“ steht hierbei stellvertretend für maschinelles Lernen, einen Teilbereich künstlicher Intelligenz.

Dieses Forschungsprojekt wird von dem Beauftragten der Bundesregierung für Kultur und Medien (BKM, Projektnummer 2522DIG002) gefördert und von der Staatsbibliothek zu Berlin durchgeführt; letztere verfügt als eine der in Deutschland führenden Kulturerbeeinrichtungen nicht nur über große Datenbestände (digitalisierte Bücher, aber auch bibliothekarische Metadaten und Bilder), sondern auch das notwendige Know-How im Bereich künstlicher Intelligenz. Daher werden in diesem Projekt intelligente Verfahren für die Dokumentanalyse entwickelt, um Volltexte und Strukturdaten (wie etwa Inhaltsverzeichnisse) aus den digitalen Beständen zu gewinnen, was bei Texten in Frakturschrift nicht trivial ist. Darüber hinaus werden illustrative Elemente aus gescannten Büchern ausgeschnitten, klassifiziert und durch Ähnlichkeitssuchen erschlossen. Die inhaltliche Erschließung von Werken – eine klassisch bibliothekarische Tätigkeit – wird durch automatische Verfahren unterstützt. Schließlich werden große Datensätze (Text, Bilder, Metadaten) als Angebote für Forschung und KI-Anwendungen zusammengestellt und öffentlich zugänglich gemacht. Die Projektlaufzeit beträgt drei Jahre (2022-2025), die erzielten Ergebnisse werden hier auf der Projektwebseite fortlaufend veröffentlicht.

Projektaufgaben (Teilprojekte und Arbeitspakete)

Das Projekt „Mensch.Maschine.Kultur – Künstliche Intelligenz für das digitale Kulturelle Erbe“ besteht aus vier Teilprojekten, die aufeinander abgestimmt unterschiedliche Zielsetzungen verfolgen und mit den dafür geeigneten KI-Verfahren kombinieren.

Teilprojekt 1 „Intelligente Verfahren für die generische Dokumentanalyse“ stellt KI-Verfahren für die Dokumentenanalyse bereit, so dass qualitativ hochwertige Volltexte und Strukturdaten aus den verschiedenen Informationen gewonnen werden können, die in den digitalisierten Beständen enthalten sind (Text, Bild, Layout). Dieses Arbeitspaket geht daher über die Erkennung von Texten in Frakturschrift hinaus, trennt Bildelemente ab und analysiert das Layout, um die systematische Auswertung von Texten wie z.B. in Zeitungen und Zeitschriften zu ermöglichen.

Teilprojekt 2 „Bildanalyseinstrumente zur Erschließung des digitalen Kulturellen Erbes“ vertieft die im Vorgängerprojekt Qurator begonnenen Arbeiten zur Bildähnlichkeitssuche durch Erkennung, Extraktion und Klassifizierung von digitalen Bildinhalten.

Teilprojekt 3 „KI-unterstützte Inhaltsanalyse und Sacherschließung“ unterstützt die Expert*innen in den Fachabteilungen der Staatsbibliothek durch semi-automatisierte Verfahren bei der inhaltlichen Erschließung und bezieht dazu systematisch deren Expertise ein. Vollautomatische Verfahren zur Erkennung von Entitäten wie Personen, Orten und Körperschaften werden dabei helfen, Material aus den digitalisierten Sammlungen noch zielgerichteter im Discovery-System der Bibliothek auffinden zu können.

Teilprojekt 4 „Datenbereitstellung und Kuratierung für KI“ bündelt und dokumentiert Datenangebote, die spezifisch für universitäre und nicht-universitäre Forschung und den Einsatz von KI aufbereitet wurden, und es macht diese Forschungsdaten öffentlich für die Nachnutzung zugänglich. Zudem werden Richtlinien darüber, wie qualitativ oder ethisch problematische Bestände und Inhalte erkannt und behandelt werden sollten, erarbeitet und mit der Community abgestimmt.

Eine Projektdarstellung auf den Seiten der Staatsbibliothek zu Berlin findet sich hier, ein einführender Blogbeitrag hier.

Alle Ergebnisse aus dem Mensch.Maschine.Kultur-Projekt werden als Open Source, Open Data und Open Access zur freien Nachnutzung zur Verfügung gestellt. Hier finden sie mehr.